互联网的发展可能走向何方

2026-01-05 中国教育网络

日前,APNIC首席科学家杰夫·休斯顿(Geoff Huston)基于ARIN 56会议上的演讲内容发表文章,从广阔的互联网行业背景出发,探讨了互联网的发展历程和未来可能的演变方向。杰夫·休斯顿认为,未来的互联网发展难以预测,部署IPv6是大规模、安全且经济地部署数字服务的有效途径。

我们的起点

我们正处于人类历史上最高产的“联姻”之一:计算与通信的结合。自1947年12月晶体管发明和1958年集成电路问世以来,世界发生了根本性变革。在此之前,人类的所有努力都受到地理条件的限制。19世纪中叶的工业时代和铁路的迅猛发展引发重大社会变革,经济的财富与权力基础从土地和农业活动转向工业生产,而电报、电话等通信技术则为这一转变提供了支撑,让工业企业得以扩展影响力、扩大生产规模。

当计算机进入通信领域后,变革速度急剧加快。从晶体管发明到集成电路问世历经十年,再到计算机成为数据处理和通信核心工具又过了十年。20世纪60年代末,贝尔实验室的肯·汤普森和丹尼斯·里奇设计出Unix操作系统,它采用C语言编写,配套编译器能为多种计算机生成汇编代码,且是当时最早的“开放”操作系统之一。这并非自主选择:1956年反垄断诉讼和解的同意令禁止贝尔系统涉足公共电信服务以外的业务,且需应要求授权专利,因此Unix无法转化为商业产品。贝尔实验室仅收介质和运输费,便向申请者提供Unix源代码,允许修改扩展,这一开放模式催生了包括伯克利软件发行版(BSD)在内的诸多变体。

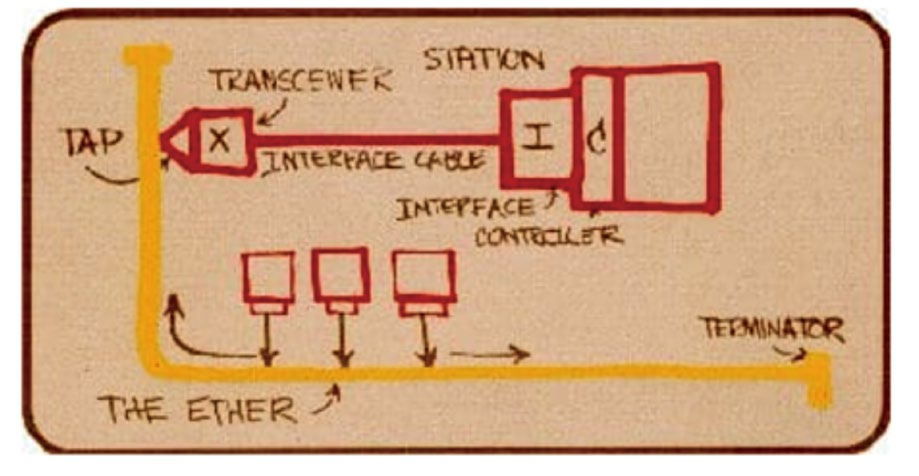

1973年,施乐帕洛阿尔托研究中心的鲍勃·梅特卡夫发表备忘录,描述了每秒300万比特的“X-Wire”共享总线局域网,后被称为“以太网”(图1)。它是计算机网络最简洁的形式:仅一根导线,无交换机、数据包帧结构等复杂组件。以太网之所以普及,是因为所有传统网络控制功能都转移到连接的计算机中,以分布式算法实现,网络本身仅用于传输,即“愚笨的网络,智能的设备”,运营成本也与网络本身无关。

图1 X-Wire框架。由鲍勃·梅特卡夫手绘,戴夫·R·博格斯于1976年拍摄,制作成35毫米幻灯片用于在全国计算机会议上展示以太网。(来源:IEEE802)

以太网局域网的“智能”赋予连接导线的计算机:数据包自同步,总长度在64到1518字节,无集中式冲突控制(采用CSMA/CD协议协商发送权限),所有计算机接收导线上的数据包,且采用至今仍在使用的48位MAC地址寻址,与Unix一样是开放标准。

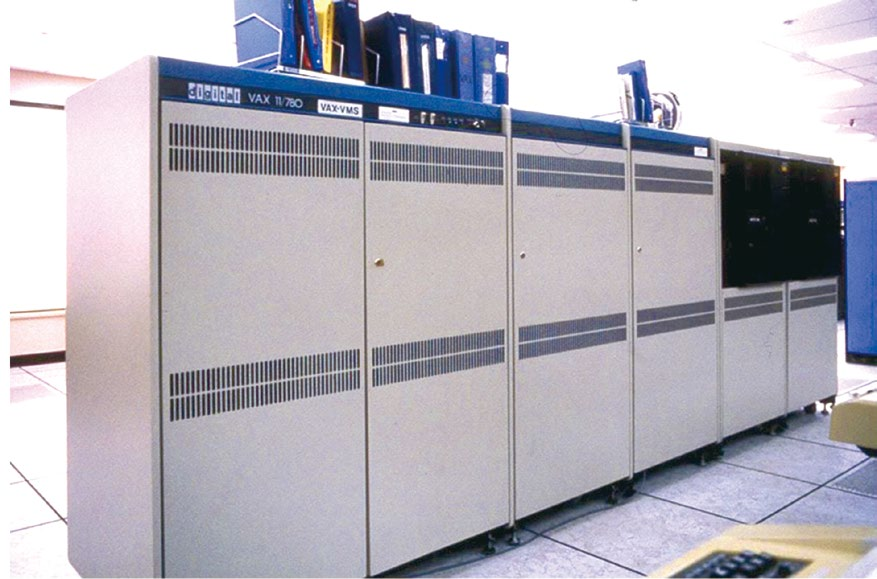

1977年,数字设备公司推出Vax11/780中型大型机,每秒可执行100万条指令,在企业、高校和研究机构中广受欢迎。观察50年历史的技术产品会发现,汽车等仍与现代产品差异不大,但50年前的计算机几乎只存在于博物馆。为何计算机行业如此愿意抛弃过去、拥抱变革?

再谈摩尔定律

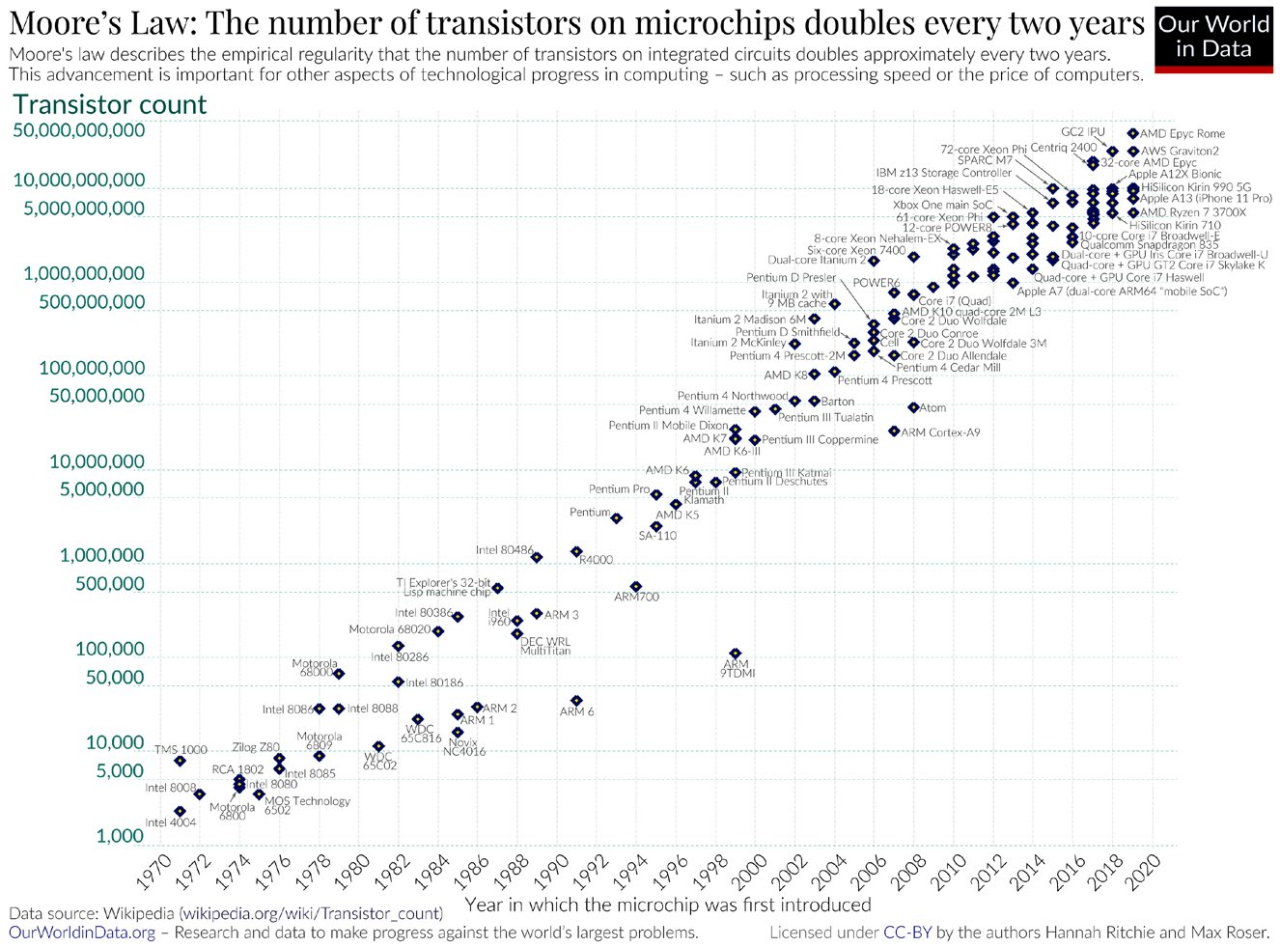

核心差异在于摩尔定律的惊人速度。英特尔联合创始人戈登·摩尔于1965年提出,集成电路上的晶体管数量约每两年翻一番,而芯片制造成本增幅远低于此。过去50年,计算能力的成本和数量持续改善(图2)。

图2 1970-2020年摩尔定律晶体管数量变化(来源:维基百科)

指数级增长难以理解,它有自身势头和意外后果。起初,摩尔定律是为让大型机更快、更小、更便宜。20世纪60年代初的大型机占满整个数据机房,使用寿命以月为单位。这种计算能力的动态演进影响了网络协议设计,计算机网络需让连接的计算机相互通信,因此每台计算机需要唯一“地址”。

Vax系统的专有协议DECnet在20世纪80年代广泛使用,采用16位地址,单个环境最多容纳65535台计算机。20世纪70年代末,数万台大型机的网络还只是幻想,但摩尔定律带来的指数级增长,让尺寸和成本骤降。20世纪80年代,计算环境转向个人计算机,20世纪70年代价值数百万美元的大型机,逐渐被小型机箱取代,走进工作场所和家庭。20世纪70年代看似用不完的16位DECnet地址,仅十年就面临耗尽的风险。

而互联网协议(IP)的研发者采取了更激进的步骤,采用32位地址架构,上限约43亿台连接设备。即便计算机进入办公室和家庭时,世界人口还不到43亿,这在当时是大胆的想法。

促成互联网爆发式增长的三大要素就此齐备:计算速度、尺寸和成本的进步;公开高效的Unix操作系统;可自由获取且因32位地址具备巨大容量的IP协议。

图3拍摄几年后,市场上出现数十万台Vax计算机,我们曾认为40亿IP地址“永远用不完”,事实却证明大错特错。摩尔定律继续推动行业变革:Vax11/780推出时,苹果发布首款计算机,价格数百美元,仅用于桌面娱乐,未挑战主流行业。但苹果创始人史蒂夫·乔布斯深知摩尔定律的意义,不仅是“更便宜、更小”,还能提升人机交互体验。苹果开发的麦金塔计算机,操作界面直观,无需专业手册,用户无需记忆复杂语言即可操作,在消费市场大获成功,个人计算机市场迅速超越大型机,主导计算领域。

图3 DEC Vax 11/780计算机(来源:维基百科)

从电话通信到广播电视

在计算机网络早期,人们视其与电话网络相同:对称且不可见,连接的设备既提供服务也访问服务,既是客户端也是服务器。但这未充分利用摩尔定律。随着更多个人计算机接入网络,它们不再兼具双角色,仅作为简单客户端,计算机逐渐分化为专用客户端和服务器。大型机未消失,而是为数百万、数千万个人计算机客户端提供服务。

计算机网络不再以电话网络为蓝本,更像广播电视:客户端自主选“节目”。家庭用户不想成为服务提供者或托管服务,仅想要“计算机版电视机”。

客户端与服务器

20世纪90年代末的互联网围绕“客户端—服务器”模式构建,因它基于电话网络搭建,而非对称行为植入互联网架构:客户端功能有限,仅能与服务器连接,仅发出“查看外部数据”的请求。

20世纪90年代的拨号上网、21世纪初的DSL/有线电视调制解调器,适配当时客户端-服务器网络需求。互联网通过改造现有最后一公里基础设施扩张,避免了服务商的巨额前期投资。数百万客户端渴望拥有个人计算机、访问数字服务,行业持续增长。2000年左右,专业数据中心出现,集中管理服务器,配备电力、冷却系统和维护人员,服务器领域也出现网络服务、邮件服务等专业化服务。与当前人工智能规模的数据中心相比,当时的互联网服务数据中心仅一两间机房,功率数百兆瓦,在线服务集中在这些专用交付点。

随着互联网向消费领域扩张,大型“网络交换中心”和“网络对等点”处理数据与服务交付的交汇,客户端间不直接交换数据,所有交易都在客户端与服务器间进行。硅芯片行业扩大客户端基础的同时,流量工程也确保网络容量这一有限资源被公平高效利用。

不再仅仅是“一根导线”

如今的网络早已不是“一根导线”,而是依赖软硬件执行资源控制、可变服务响应、防御措施和数据收集等功能。摩尔定律推动服务交付平台处理能力提升,功能不断增强,且硅芯片能力的进步还体现在数据中心服务和网络中间件之外。

当激光穿过光纤、通过通断键控调制光信号承载数字信号时,仅需简单光检测器;若想提升光纤容量,可采用模拟调制解调器的信号调制技术,对光信号进行相位和幅度调制。这种方法能大幅提升容量,但实践限制取决于两端信号处理能力。借助先进数字信号处理器(DSP),可通过光纤传输接近每秒1太比特的信号。采用3纳米芯片技术,单偏振光信号每秒800吉比特的传输速率已能实现;同时,最新一代DSP将常见网络承载容量提升至100~200吉比特。

富足的网络

这些发展让网络角色巨变:传输容量稀缺时,网络需分配资源访问权,控制者可收“稀缺溢价”;但容量充足到满足所有需求时,网络运营商沦为无差异化的商品经纪角色,股价随这一转变大幅下跌。

网络运营行业试图为网络增加可变服务响应、网络分段等功能,却只增加成本,未吸引客户端的兴趣。技术进步也让连接设备能自主管理服务响应需求,在网络富足环境中,网络服务成了无差异化商品,按此定价。

硅芯片行业转向手持和嵌入式设备后,再次超额完成目标:短短几年内,数十亿设备接入互联网,形成以充足处理能力、存储和传输容量为特征的数字世界。在富足环境中,用于配给有限资源的定价失去意义,这对网络运营商是挑战。他们在历史上的角色是共享有限资源,但网络基础设施价值已大幅降低。

网络作为“即时”服务的角色,多被内容分发网络(CDN)取代。CDN将服务内容副本部署在大量服务点,采用“以防万一”模式,把内容推到网络边缘,靠近潜在消费者。这带来连锁反应:内容和服务靠近用户,网络范围缩小,距离不再是主导特征,数据包传输里程变短。将网络从全球或跨大陆范围缩小到单个城市,一切都会更简单、更快、更便宜;若能构建像局域网一样的互联网,稀缺性和性能问题也会大幅减少。

更大、更快、更便宜

如今距离缩短的互联网反而“更大”:核心系统容量达太比特级,边缘网络(最后一公里光纤和无线电)达吉比特级,内容同时在各地发布,网络是“容量上的大”而非“距离上的大”,距离缩短也让协议性能提升、成本降低。

当前网络速度极快:家庭网络带宽达每秒1吉比特,还能以相同速度从协作服务器下载内容。更短的距离提升了性能,因网络传输协议是反馈控制的,两端距离近,单位时间反馈周期多,信息流能指导协议优化交付效率。

网络也更便宜:将每秒1吉比特互联网服务费用折算到1975年,每月100美元仅相当于当时的17美元;近地轨道卫星服务还将互联网延伸到地球最偏远角落。硅芯片制造技术的持续改进,造就了更优质、更快、更便宜的网络。

摩尔定律的终结?

过去50年,摩尔定律推动行业进步,但我们是否接近其终点?当前硅芯片特征尺寸为3纳米,2纳米看似可以实现。而硅原子直径约0.23纳米,2纳米特征尺寸仅相当于10个硅原子宽度。

1纳米特征尺寸是否可能?极紫外光刻技术已用于产生13.5纳米波长的芯片光刻,但过程极其复杂。

即便有可靠可扩展的光刻工艺,电子问题也不容忽视:假设电子是粒子,在极小空间内会表现出不确定性,用当前平面集成电路技术很难进一步缩小芯片特征尺寸。1957年制造集成电路的工艺虽逐年改进、特征尺寸缩小,但这一过程可能陷入停滞。今年无人宣布推出4万亿晶体管的硅芯片,未来也未必有。当前技术已接近物理极限,下一项创新需突破性智慧。

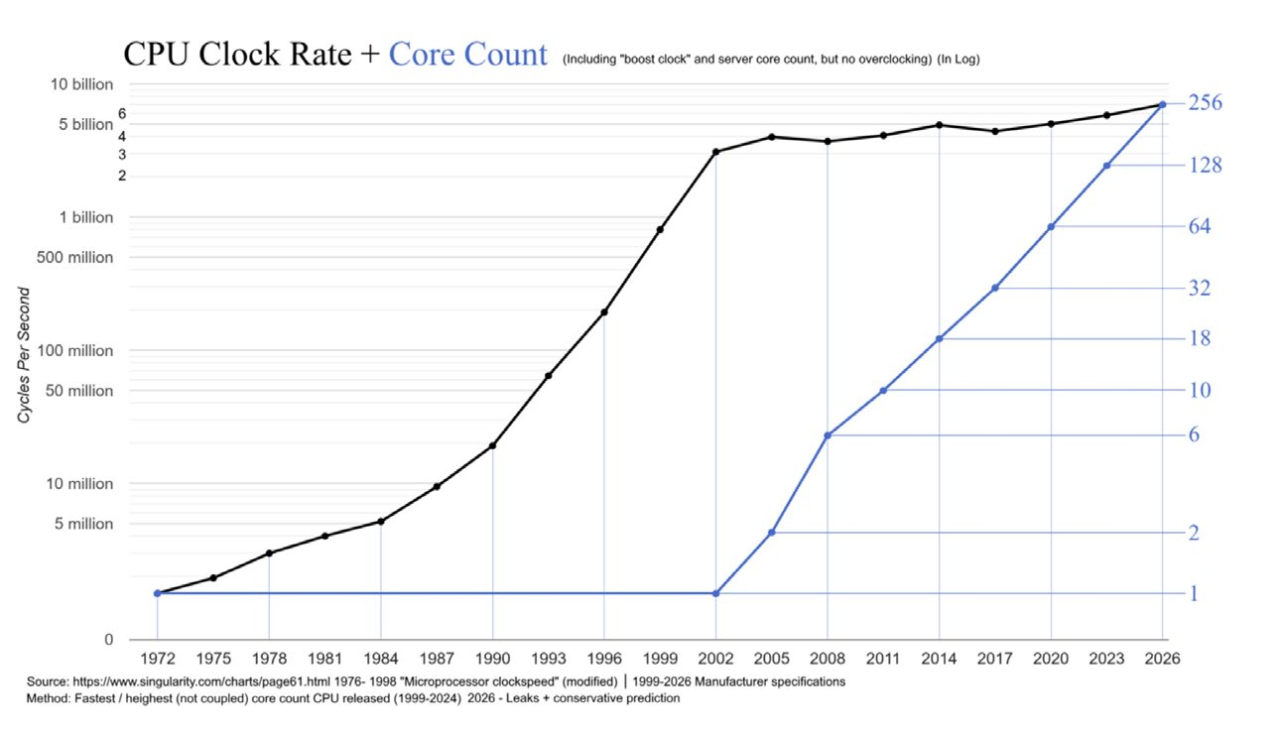

此外,处理器时钟速度在2000年左右达到峰值,虽晶体管数量和CPU核心数增加,但时钟速度基本稳定(图4)。现在宣布摩尔定律终结尚早,但我们应思考:若这一“馈赠”停止,会带来什么影响?

图4 CPU时钟频率变化(来源:维基百科)

IPv6与IP地址

这与IPv6部署有何关联?20世纪90年代初,为解决连接设备数量超32位地址空间容量的问题,IP协议被重新定义为128位地址字段,保留互联网所有特性。但因缺乏向后兼容性,网络用户和运营商需承担采用新协议的成本,却未获全新协议的收益,它仍只是IP协议。

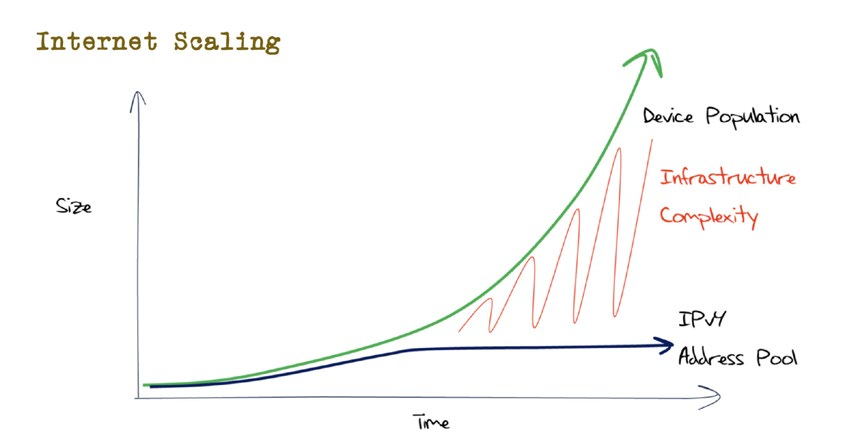

当时还有另一种选择:部署网络地址转换(NAT)设备。NAT是客户端侧方案,用更强处理能力弥补IPv4地址不足,但仅当处理效率能随需求增长扩展时,才具备长期可行性。NAT旨在弥合现有技术能力与网络规模的差距,但网络增长让差距扩大,基础设施复杂性成本飙升(图5)。

图5 弥补IPv4地址差距

届时,网络中的内置处理能力会成问题,因为它是成本要素,而商品网络长期难以承受成本。用NAT应对IPv4地址耗尽问题,几乎无法降低网络复杂性,而要大规模、安全且经济地部署数字服务,必须降低复杂性,部署IPv6便是明确途径。

印度在2017年领会到这一点,12个月内为10亿用户部署IPv6网络,规模和速度前所未有;中国也面临类似问题,加快了IPv6部署进程。

还有一种趋势:价值从协议层向应用层转移,应用本身就是服务。由此我们不禁发问:IP地址还重要吗?答案是“当前还很重要”。

网络即市场

故事尚未结束。硅芯片行业仍全速运转,预计所有处理器最终会以某种形式用于互联网连接设备,网络需进一步扩展,挑战在于服务级别的扩展——协调网络组件行为,产生协调结果。但我们并不完全清楚如何实现。

别忘了,互联网并非中央规划的全球事业,没有任何个人、实体或组织能掌控。也没有专门国际条约、公约或协议监督互联网,无强制控制互联网,甚至无明确发展方向。

互联网是各类市场的集合,无论规模大小。市场协调行为者行为以产生一致结果,同时也试图最大化传输效率(尽管不完美)。然而,市场的表现未必遵循理性,甚至难以预测。当我们凝视互联网的水晶球,试图对其未来做出预言时,所见景象宛如隔着一层晦暗的玻璃——朦胧而失真。

来源:APNIC

作者:杰夫·休斯顿(Geoff Huston)

责编:项阳

编译:李想

特别声明:本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者在两周内速来电或来函联系。

相关阅读

APNIC 60会议在越南岘港召开2025/09/16

星链表现出的多面性:好的坏的和令人讨厌的2024/11/18

气候变化将给海底光缆带来哪些压力?2024/09/30

APRICOT 2024&APNIC 57在泰国曼谷开幕2024/03/05

APNIC主席Paul Wilson:互联网治理需多方参与2019/01/17

重磅!APNIC:中国IPv6突然加速!2019/01/03

APNIC第36次会议助力亚太IPv6发展2013/09/11

第36届APNIC开幕在即 推动我国IPv6规模商用2013/08/20

星链表现出的多面性:好的坏的和令人讨厌的2024/11/18

气候变化将给海底光缆带来哪些压力?2024/09/30

APRICOT 2024&APNIC 57在泰国曼谷开幕2024/03/05

APNIC主席Paul Wilson:互联网治理需多方参与2019/01/17

重磅!APNIC:中国IPv6突然加速!2019/01/03

APNIC第36次会议助力亚太IPv6发展2013/09/11

第36届APNIC开幕在即 推动我国IPv6规模商用2013/08/20

一起关注互联网发展、互联网技术、互联网体系结构……

在教育部科技司领导下,中央电化教育馆组织实施了教育信息化教学应用实践共同体项目...

工作要点聚焦:教育信息化、网络安全……都怎么干?

京公网安备 11040202430174号

京公网安备 11040202430174号