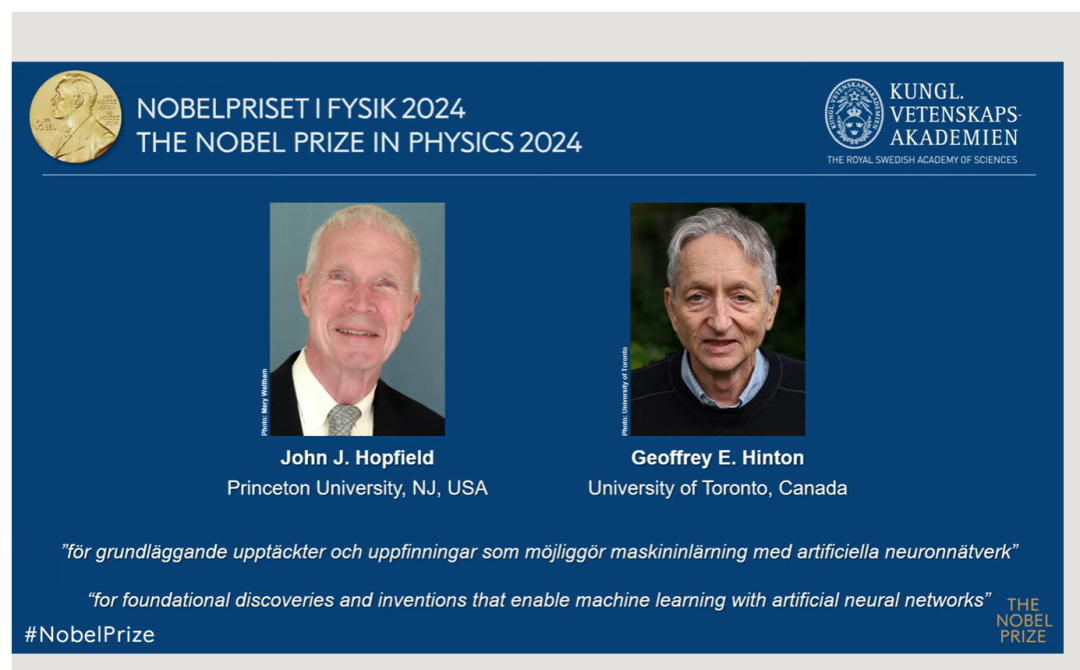

2024年诺贝尔物理学奖10月8日揭晓:

76岁的多伦多大学计算机科学家

杰弗里-欣顿(Geoffrey Hinton)

与美国普林斯顿大学名誉教授

约翰-霍普菲尔德(John Hopfield)

8日共同获得诺贝尔物理学奖

以表彰利用人工神经网络进行机器学习的基础发现和发明

“for foundational discoveries and inventions that enable machine learning with artificial neural networks”

被称为人工智能教父的欣顿8日在美国加利福利亚得知获奖后说:“我们并不知道机器比人更聪明会发生什么(”We have no experience of what it‘s like to have things smarter than us“)。” 欣顿曾说,机器比我们想象的更接近人类。他对技术的危险发出警告并离开了谷歌。

研究“机器学习”为何获得“物理学”奖项?

官方解读:

他们用物理解码信息

这也凸显了跨学科研究的惊人力量

后附官方解读,以飨读者

2024年诺贝尔物理学奖跟图灵奖“抢饭碗”?

——机器学习获诺奖凸显跨学科研究的惊人力量

新华社记者郭爽

8日宣布的2024年诺贝尔物理学奖“意外”垂青机器学习,让多个诺奖预测集体“翻车”,就连获奖者之一的杰弗里-欣顿也坦言自己“完全没想到”。看似不属于传统物理学任何一个分支领域的成果斩获诺奖,让不少学者开玩笑说诺贝尔物理学奖在跟计算机界的图灵奖“抢饭碗”。

事实上,机器学习领域的元老级人物约翰-霍普菲尔德和杰弗里-欣顿斩获诺奖,如诺奖官方公告所说正是因为“运用物理学的工具”。今年的诺贝尔物理学奖不仅是对两名科学家成就的肯定,更是极大强调了跨学科研究的重要性,向人们展示了物理学的深刻洞见与计算机科学创新“碰撞”可以产生的巨大能量。

当前人们谈论人工智能时,经常指的是使用人工神经网络的机器学习。诺贝尔物理学委员会秘书乌尔夫-丹尼尔松对记者强调,人工神经网络在物理学中的研究和应用已经持续了相当长一段时间,本次诺贝尔物理学奖并非颁发给过去几年人工智能的发展,不是针对大语言模型或类似的东西,而是针对基础发明。

远在人工智能成为今天的科技热词之前,这两名科学家从20世纪80年代起就在人工神经网络领域做出了重要工作。这项技术最初的灵感来自大脑的结构。就像大脑中大量神经元通过突触相连一样,人工神经网络由大量的“节点”通过“连接”组成。每个节点就像一个神经元,而连接的强弱则类似于突触的强度,决定了信息传递的效果。

1982年,美国科学家约翰-霍普菲尔德创建了一种用于机器的联想记忆方法,提出了一种革命性的网络结构,被称为“霍普菲尔德网络”。这个网络能够存储多个模式(比如图像),并且在面对不完整或有噪声的输入时,能够重构出最相似的模式。

英国裔加拿大科学家杰弗里-欣顿在此基础上更进一步,他希望机器能像人类一样自主学习和分类信息,于1985年和同事提出了“玻尔兹曼机”的网络模型,这个名字源于19世纪物理学家路德维希·玻尔兹曼的方程。该模型通过统计物理学中的玻尔兹曼分布来识别数据中的特征,成为了现代深度学习网络的基础。欣顿的研究继续推进,导致了当前机器学习领域爆炸式的发展。

爱尔兰都柏林圣三一学院认知神经科学教授罗德里·丘萨克8日评论指出,人工神经网络最初受到神经科学的启发,并且两者之间的相互作用持续蓬勃发展。人工神经网络已被证明是大脑学习过程的宝贵模型,机器正在帮助我们了解自己,这反过来又为技术发展提供了新的途径。如果没有霍普菲尔德和欣顿的开创性工作,这一切都不可能实现。

霍普菲尔德和欣顿的工作不仅推动了机器学习的发展,还对物理学产生了深远影响。正如丹尼尔松当天在接受新华社记者采访时所说,物理学的原理为两名科学家提供了思路,同时,人工神经网络在物理学中也得到了广泛应用,催生新的惊人发现。

诺贝尔物理学委员会主席埃伦·穆恩斯在当天的新闻发布会上表示,两名获奖者利用统计物理的基本概念设计了人工神经网络,构建了机器学习的基础。相关技术已被用于推动多个领域的研究,包括粒子物理、材料科学和天体物理等,也已用于日常生活中的人脸识别和语言翻译等。

机器学习的迅速发展不仅带来了巨大的机遇,也引发人们对于伦理和安全方面的担忧。穆恩斯当天在发布会上强调说,人类有责任以安全且道德的方式使用这项新技术,以确保它能为全人类带来最大的利益。

欣顿当天在接受电话连线采访时表示,这一技术将对社会产生巨大影响,但也必须警惕这一技术可能造成的威胁。丹尼尔松也指出,机器学习与基因编辑等众多前沿技术的发展是“双刃剑”,人们必须警惕出现坏的结果。在这方面,尤其需要全球合作。

2024年诺贝尔物理奖官方解读:

他们用物理解码信息

今年的获奖者利用物理学工具构建了一些方法,为今天强大的机器学习奠定基础。约翰·霍普菲尔德(John Hopfield)创造了一种可以存储和重构信息的结构。杰弗里·欣顿(Geoffrey Hinton)发明了一种可以独立发现数据属性的方法,这种方法对于现在使用的大型人工神经网络非常重要。

许多人都有过使用计算机进行翻译、图像解读,甚至一些合理对话的经历,但是大家可能不知道的是,这种技术长期以来对物理学研究工作也是非常重要的,包括对海量数据进行分类和分析。机器学习利用了一种叫做人工神经网络的结构,在过去的十五到二十年里,它的发展呈现出爆炸式增长。如今,当我们谈论人工智能时,我们通常指的就是这种技术。

虽然计算机不能思考,但是它们可以模拟记忆和学习等功能。今年的物理学奖得主让这一点成为了现实。他们利用物理学的基本概念和方法,开发出了利用神经网络结构处理信息的技术。

机器学习的工作方式不像传统软件那么简单和程序化。传统软件接收数据,根据明确的命令进行处理,然后产生结果,就像有人收集配料并按照食谱进行加工,从而制作出蛋糕一样。与此相反,在机器学习中,计算机通过实例进行学习,使其能够处理非常模糊和复杂的问题,而这些问题是无法通过一步步的命令来处理的。很著名的一个例子就是图像识别。

对大脑神经系统的仿生学设计

一个人工神经网络需要利用整个网络架构来处理信息。这个想法最初脱胎于科学家们对理解大脑如何工作的相关研究。在20世纪40年代,研究人员已经在对于如何理解或模仿大脑的神经和突触的功能的数学原理展开研究。关于如何模拟并实现类似神经功能的相关进展还来源于心理学,这得归功于神经学科学家唐纳德·赫布对于大脑如何实现学习这一行为的猜想。赫布认为当大脑开始学习时,大脑中的神经元开始集体工作,传递信息,神经之间的连接,例如神经突触会得到加强。

在接下来的研究中,在对于大脑数学和神经学研究的基础上,科学家们开始尝试通过计算机模拟的方式在硅基芯片上构建人工神经网络,实现类似大脑的神经网络的功能。其中,科学家们在计算机中构建被赋予不同初始值的节点来模拟大脑中的神经元,并以这些节点之间的关联来模拟神经元之间的突触,其中节点之间的关联程度随着程序的执行会变得更强或更弱。直到现在,唐纳德 赫布的理论仍然是科学家们通过训练这一方法发展神经网络所遵循的基本规则之一。

在20世纪60年代左右,当时关于神经网络的理论研究却无法成功得到理想的结果,理论预言上的失败使得一些研究人员开始对神经网络是否能够被真的投入到实际使用中产生了怀疑。然而,在20世纪80年代,随着新的神经网络理论的提出并得到关注,包括今年的诺贝尔物理学奖得主Hopfield提出了新的重要观念,科学界又掀起了一股神经网络的研究热潮。

联想记忆

想象一下,你试图回忆一个相当不寻常且很少使用的生僻单词,比如用于描述电影院或者无障碍通道中那种倾斜地面的词汇。你在记忆中搜索。它长得有点像斜面(ramp)... 还是说滑坡 (radial)?不,不是那个。斜坡(Rake),就是这个!

这种通过搜索相似单词来找到正确单词的过程让人想起物理学家约翰·霍普菲尔德于 1982 年发现的联想记忆。霍普菲尔德网络是一种可以存储模式的网络,它还包含一种可以重新找到这些模式的方法。当人们给这个网络输入不完整或略有失真的模式时,该方法可以在已存储的模式中找到最相似的模式。

霍普菲尔德曾利用他的物理学背景去研究分子生物学中的理论问题。他在受邀参加一次会议时接触到了关于大脑结构的研究。他在这次会议中所学的知识令他十分着迷,于是他开始思考简单神经网络的动力学。当神经元共同作用时,它们会产生新的强大特性,而这些特性是神经网络的单个组成部分所不能表现出来的。

1980年,霍普菲尔德辞去了他在普林斯顿大学的职位。当时,他的研究兴趣已超出他物理学领域的同事们的研究范围。随后,他跨越整个大陆,接受了位于加利福尼亚州南部帕萨迪纳的加州理工学院(California Institute of Technology)的教职邀请,成为化学与生物学教授。在这里,他获得了充足的计算机资源,供他自由地实验并发展自己关于神经网络的理论。

然而他并没有忘记他是一个物理学家,他的物理基础给他带来了灵感,从而帮他理解了由许多小的组成部分共同运作的系统如何产生新的、有趣的现象。他尤其受益于对磁性材料的了解,这种材料的特殊性质来源于构成它们的原子所具有的自旋——这种特性使每个原子都成为一个微小的磁铁。相邻原子的自旋相互影响;这可以形成自旋方向相同的区域。他运用描述自旋相互影响时材料如何发展的物理学,构建出具有节点和连接的模型网络。

神经网络用“地形”构建图像

霍普菲尔德构建的网络具有以不同强度相互连接的节点。每个节点可以存储一个单独的值——在霍普菲尔德的最初工作中,这个值可以是0或1,就像黑白照片中的像素一样。

霍普菲尔德用与物理学中自旋系统能量等同的一个概念来描述网络的总体状态;并通过一个公式计算这个能量,这个公式包含了所有节点的值和它们之间的连接强度。霍普菲尔德网络通过将图像输入到节点中进行初始操作,节点被赋值成黑色(0)或白色(1)。然后使用计算能量的公式调整网络的连接强度,以使得最终的图像满足能量最低原理。当另一个模式被输入时,这个网络则会逐个检查节点,看如果改变该节点的值,网络的能量是否会降低。如果发现如果黑色像素变成白色,能量会降低,它就会改变颜色。这个过程一直持续到不可能找到任何进一步的改进为止。当实现这一点时,网络通常能够再现它所训练的原始图像。

如果你只保存一个模式,这可能看起来没什么特别的。也许你会想,为什么不直接保存图像本身,并将它与正在测试的另一张图像进行比较,但霍普菲尔德方法的特别之处在于它可以同时保存多张图片,网络通常能够区分它们。

霍普菲尔德将搜索网络来寻找合适状态的过程比作在有摩擦力的起伏地面上滚动一个球。如果球被放在某一个位置,它会滚进最近的山谷并停在那里。如果网络被赋予一个接近最优状态的模式,它同样也会向前“滚动”,直到它最终到达能量最低的一个“山谷”,从而找到存储中与之最接近的模式。

霍普菲尔德网络可以用来重现包含噪声或已被部分擦除的数据。

霍普菲尔德和其他研究者继续发展了霍普菲尔德网络的功能细节,比如节点可以存储任何值,而不仅仅是零或一。如果你将节点想象成图片中的像素,它们可以有不同的颜色,不仅仅是黑色或白色。改进的方法使得网络可以保存更多图片,并且在它们非常相似时也能加以区分。只要需要处理的信息是由许多数据点构建的,那么就可以识别或重建它们。

使用十九世纪物理学进行分类

记住一幅图像是一回事,但解释它所描绘的内容需要更多技巧。

即使是非常小的孩子也能辨认出不同的动物,并自信地说出这是狗、猫还是松鼠。即使他们有时可能会犯错,但很快就能做到准确无误。比如识别“物种”或“哺乳动物”一样,孩子即使没有看到任何动物的图解或概念解释,也能学会这些概念。经历过几个例子的学习后,每种动物的不同类别就会在孩子的脑海中形成清晰的图像。人们通过体验周围的环境,学会识别猫,理解一个词,或者察觉到房间里有什么变化。

当霍普菲尔德发表其关于联想记忆的文章时,杰弗里-欣顿正在美国宾夕法尼亚州匹兹堡的卡内基梅隆大学工作。他此前在英国研究实验心理学和人工智能,并在思考机器是否能以类似于人类的方式学习信息处理方法,对信息进行分类和解释信息的类别。他与同事特伦斯-塞金诺斯基(Terrence Sejnowski)一起,从霍普菲尔德网络出发,借鉴统计物理学的观点构建了一种新的方法。

统计物理学描述的是由许多相似物质组成的系统,例如气体中的分子。追踪气体中某个单独的分子是困难的,甚至是不可能的,但可以将它们综合在一起来确定气体的整体性质,如压力或温度。气体分子在其体积中扩散的方式有许多种可能,其中每个分子以不同的速度移动,但最终还是形成了相同的集体属性。

系统中各个组分能够共同存在的状态可以通过统计物理学进行分析,并且这些状态发生的概率也可以被计算出来。有些状态比其他状态更有可能发生,这取决于系统能量,这些可以通过十九世纪物理学家路德维希-玻尔兹曼(Ludwig Boltzmann)提出的方程式描述。欣顿的网络算法利用了这个方程,其方法在1985年以“玻尔兹曼机”(Boltzmann machine)这一著名的名称发表。

识别相同类型的新样本

玻尔兹曼机通常使用两种不同类型的节点。一组节点被称为“可见节点”,用来输入信息。另一组节点则组成一个隐藏层。隐藏节点的值和它们之间的连接也会对整个网络的能量产生影响。

该机器通过应用一套规则来运行,每次更新一个节点的值。最终,机器会进入一种状态,在这种状态下节点的模式可以变化,但整个网络的属性保持不变。每种可能的模式都会有一个特定的概率,这个概率是由根据玻尔兹曼方程计算出的网络能量决定的。当机器运行结束时,它会创造出一个新的模式,这使得玻尔兹曼机成为生成模型的早期范例。

玻尔兹曼机可以通过提供的训练样本进行学习,而不是通过指令。它通过更新网络连接中的值进行训练,以使训练时输入到可见节点的示例模式在机器运行时具有尽可能高的出现概率。如果在训练过程中重复同一模式多次,该模式的概率会进一步提高。训练还会影响输出新模式的概率,这些新模式与机器训练时的示例相似。

训练好的玻尔兹曼机能够在先前未见过的信息中识别出熟悉的特征。想象一下,你遇到朋友的兄弟姐妹,你可以立即看出他们一定有亲属关系。类似地,玻尔兹曼机可以识别一个完全新的样本,只要它属于训练材料中已存在的类别,并且能将其与不相似的材料区分开来。

玻尔兹曼机的原始形式效率较低,需要较长时间才能找到解决方案。当它被进行各种改进时,就变得更加有趣,欣顿对此继续进行了研究。后来的版本进行了“瘦身”,即去除了一些单元之间的连接。事实证明,这可以使机器更加高效。

在20世纪90年代,许多研究人员对人工神经网络失去了兴趣,但欣顿是少数仍坚持在该领域工作的研究者之一。他还推动了新一轮激动人心的研究成果的爆发;2006年,他和他的同事西蒙-奥辛德罗(Simon Osindero)、郑宇怀(Yee Whye Teh)以及鲁斯兰·萨拉霍丁诺夫(Ruslan Salakhutdinov)开发了一种方法,通过一系列层叠的玻尔兹曼机对网络进行预训练。这种预训练为网络中的连接提供了一个更好的起点,从而优化了识别图片元素的训练过程。

玻尔兹曼机通常作为更大网络的一部分使用。例如,它可以根据观众的偏好推荐电影或电视剧。

机器学习的现今与展望

约翰-霍普菲尔德和杰弗里-欣顿从20世纪80年代起就在此领域深耕,为2010年左右开始的机器学习革命奠定了基础。

我们现在所看到的如此规模的计算机神经网络是通过获取可用于训练网络的大量数据以及计算能力的巨大提升发展而来的。现今的人工神经网络通常是巨大的,由许多层组成。这些被称为深度神经网络,它们的训练方式被称为深度学习。

让我们回顾霍普菲尔德在1982年发表的关于联想记忆的文章,来为这一领域的发展提供一些视角。在实验中,他使用了一个有30个节点的网络。如果所有节点相互连接,则连接数为435。每个节点上有一个值,再加上连接有不同的强度,总共有不到500个参数需要跟踪。他还尝试了一个有100个节点的网络,但这对于他当时使用的计算机来说太复杂了。我们可以将其与今天的大型语言模型进行比较,后者是由包含超过一万亿参数的网络构建的。

许多研究人员正在开发机器学习的应用领域。哪种技术最可行还有待观察,同时围绕这项技术的开发和使用的伦理问题也有广泛的讨论。

来源 | 新华社、中科院物理所、瞭望微信号

特别声明:本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者在两周内速来电或来函联系。