李星

CERNET网络中心副主任、清华大学教授

对于人工智能领域来说,ChatGPT是一个崭新的起点。虽然它给出的内容对错参半,但是它可以帮助我们拓宽思路,给予我们新的灵感。ChatGPT的成功无疑是巨大的,那么它为什么成功,我们能从中学到点什么,理解出什么,都值得进一步分析。

ChatGPT的理论基础与“无限猴子定理”

ChatGPT是一个大语言模型(Large Language Model)。一般来说,语言模型有两种,分别是next token prediction和masked language modeling。Next token prediction指单向推导,即知道最前面的话,一步步推导出后面的话,每次推导时都找最有道理的一个字,从而递归串出一整句话。另一种则是先确定开头结尾的内容,据此去推测中间的内容。

有一个定理叫做“无限猴子定理”,而ChatGPT可以说就是一只升级版的、讲逻辑、懂道理的猴子。

“无限猴子定理”认为,让一只猴子在打字机上随机地按键,当按键时间达到无穷时,猴子几乎必然能够打出任何给定的文字,比如莎士比亚的全套著作,也曾有人用电脑虚拟的猴子来模拟执行这一定理。2004年8月4日,电脑模拟的猴子在经过4.21625×10^28个猴年之后,打出了以下内容“VALENTINE.Ceasetoldor:eFLPOFRjWK78aXzVOw- m)-;8t......”而这胡乱敲打出的前十六个字母,正属于莎士比亚的剧作《维洛那二绅士》的第一行:VALENTINE: Cease to persuade, my loving Proteus.

如果说猴子的选择来自于纯粹的巧合、运气与概率,那么ChatGPT的选择则是基于模型运算,把大概率有用的字词留下,无用的字词撇去,从而得到一句符合人类逻辑的话。

没有试错就没有ChatGPT

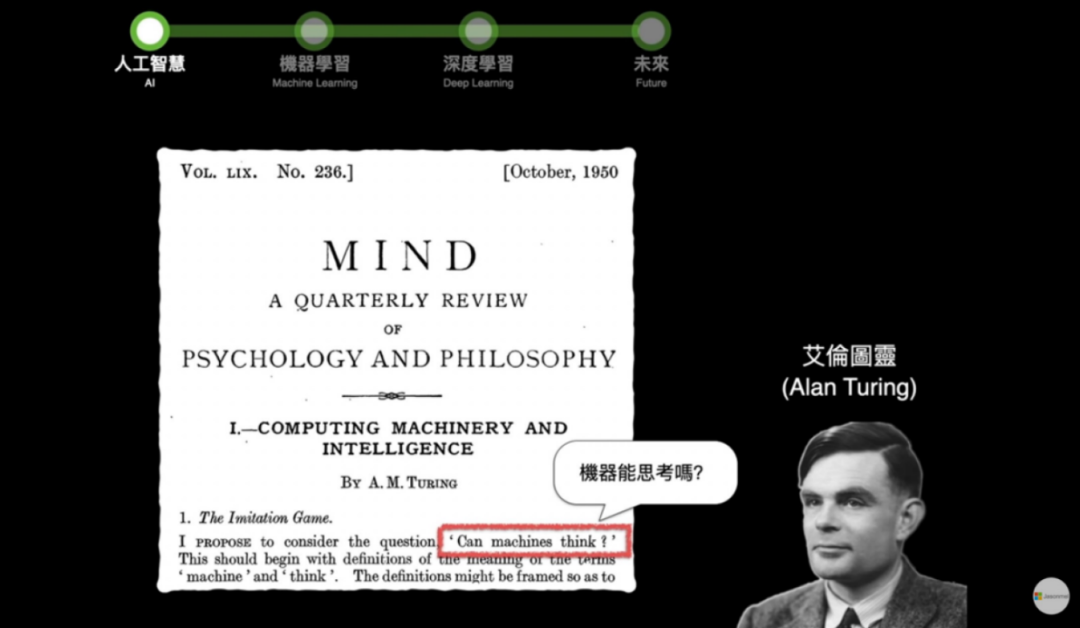

人工智能的发展历程大概可分为三个阶段。1950年图灵最早提出了人工智能的概念,他在论文中直截了当地提问,“机器是否可能具有人类智能?”开创了人工智能领域的先河。

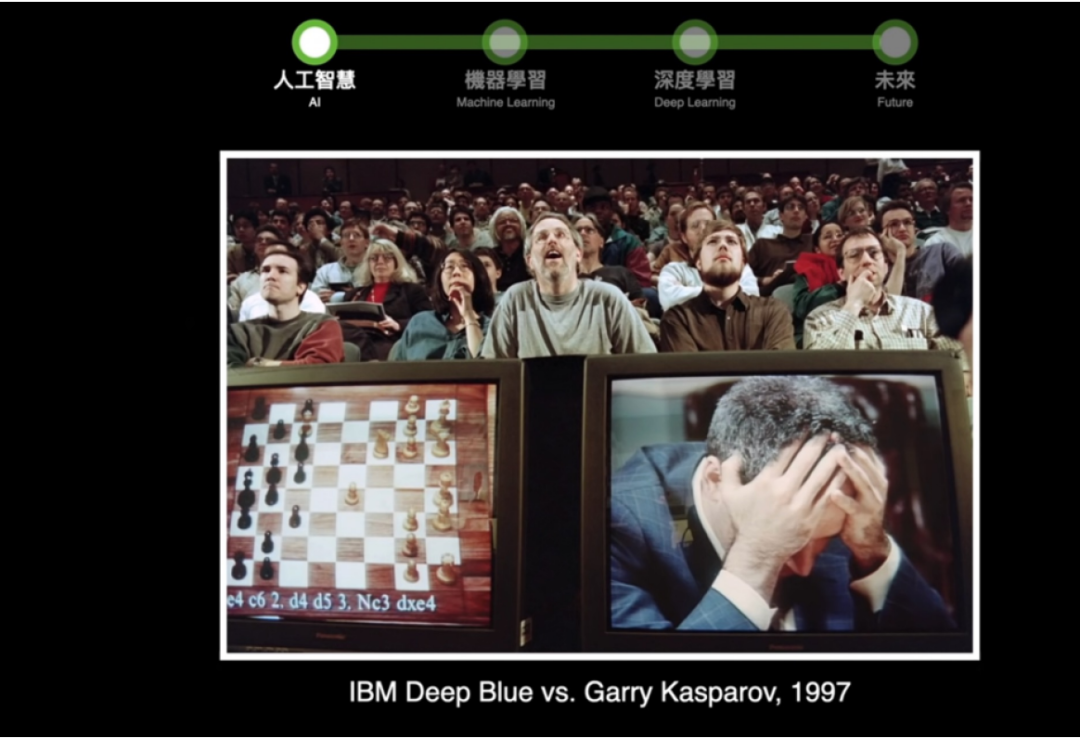

1997年,IBM的超级计算机“深蓝”(Deep Blue)以2胜1负3平的成绩战胜了当时世界排名第一的国际象棋大师加里-卡斯帕罗夫,一时间轰动全球。但是,“深蓝”还算不上足够智能,因为它的算法核心是暴力搜索,换言之,它每走一步,都是在穷举后续所有可能的情况下再做出决策。再后来,机器学习算法如雨后春笋般涌现,包括线性回归法、逻辑回归法、决策树法、随机森林法、最近邻居法、贝叶斯法、支持向量机法、 k 平均法、强化学习法等,每一个新算法都是对旧算法的改进与提升。

艾伦-图灵与其论文

深蓝打败象棋大师加里-卡斯帕罗夫

机器学习的常见方法

最简单的方法是线性回归,如果对数据进行线性回归后发现依然有问题,那就在此基础上做逻辑回归;但选项也可能不止A、B两种,此时我们就构造决策树呈现出多种选择;但决策树是一门走过去,如果决策错了怎么办?于是就出现了随机森林算法,用多棵随机生成的决策树来生成最后的输出结果。

所以说每一个理论、算法都是研究人员在前人的基础上探索、摸索而来,是一代代人不断在已有的基础上创新、更新,思考下一步如何做得更好,而非一开始就设计、锚定了最终结果。

机器学习中主要有三类学习的方式,分别是监督式学习、非监督式学习和强化学习。监督学习是从外部监督者提供的带标注训练集中进行学习(任务驱动型)。非监督学习则是一个典型的寻找未标注数据中隐含结构的过程(数据驱动型)。强化学习则会告诉模型自身好不好,给予模型更大的探索自由,从而突破监督学习的天花板。

三者之间也是渐进式前进的关系,为了应对更多问题,人们总是基于一个已有的方法,想方设法找出一个更一般性的方法进行超越,超越完成后自然进入下一个阶段。

随着数据量的增加,传统的机器学习方法表现得不尽人意。在监督式学习下就出现了一个崭新的分支——深度学习。深度学习的基础是神经网络,即通过模拟人的神经元系统做出判断。神经网络有输入层、输出层和隐藏层,输入通过非线性函数的加权后得到了最终的输出,而我们要做的就是根据误差准则调整权重参数,不需要,也不可能完全知道这些参数选择的具体原因。

神经网络模型示意图

什么叫深度学习?神经网络的层数直接决定了它对现实的刻画能力,但是原来隐含层只有一层,对稍微复杂一些的函数都无能为力。为此,就可以多加一些隐含层,深度学习由此诞生。早期的深度学习又有两个常用的方法,即卷积神经网络(CNN)与循环神经网络(RNN),前者专门解决图像问题,最大利用图像的局部信息,将局部特征拼接起来,从而得到整幅图的特征,类似于通过拼图来还原图像;后者则专门解决时间序列问题,用来提取时间序列信息,其最重要的特征是具有时间“记忆”的能力,就像人只有记住前面的对话内容,才能决定之后该说什么一样。

此外,生成模型也是深度学习领域内较为重要的一类模型。生成对抗网络(GAN)是一种让两个神经网络相互博弈从而完成学习的生成模型,其由一个生成器和一个判别器组成。比如说,生成器生成了一只虚拟狗,判别器需要将其与真实世界中的狗作对比,并判断虚拟狗是否“过关”,生成器和判别器相互对抗、不断学习,最终目的是使虚拟狗无限接近于真实的狗,让它通过判别器的检验。

自此,三大模型流派形成—— CNN,RNN和GAN,语言模型属于RNN模型之流。但RNN模型依旧有其缺陷,对于相隔越久的信息,它的记忆力就越差,那么对于过去很久但有用的信息,它就很容易遗漏。为了提高RNN的记忆力,人们又开发了Self-attention自注意力模型,运用抓大放小的思想,不管重要的东西在哪,都更注重对它的加权,强化对它的注意力,让模型牢牢将其印入“脑海”。

在上述各类模型的基础上,ChatGPT的核心结构——Transformer模型横空出世,中文翻译也很恰切,译为变形金刚。

那什么是变形金刚?简单来说,它就像是一个黑盒子,在做文本翻译任务时,我们输入一个中文,经过这个黑盒子,就得到了翻译后的英文。

如果我们探秘黑盒中的内容,可以看到黑盒由若干个编码器(Encoder)和解码器(Decoder)组成,同时盒子里还具备并行(Multi-headed)和自注意力(Self-attention)机制,自注意力机制负责挑选出重要的有用的信息,并行机制则负责对这些信息进行并发处理,有了这两大特性,变形金刚也就可以同成千上万人同时对话,奠定了商业化的基础与可能。

回溯人工智能的历史,可以发现模型的成功归根结底来源于试错。一开始是简单的人工神经网络,后来是卷积神经网络、递归神经网络,每一步都使我们对模型的理解愈发深入。而在用其解决问题的过程中,一旦发现现有方法的不足,研究人员就会想方设法在原有基础上改进,从而开发出新的模型。

虽然我们看到了成功的CNN、RNN模型,但在我们的视野之外,可能还会有别的模型沉寂于历史长河中。但是,看不到不意味着不重要。如果没有那些失败的尝试帮助我们排除了错误的技术路线,就不会有CNN、RNN的成功,变形金刚的成功和ChatGPT的出现更无从谈起。

所以创新、创造都是在不断试错、迭代中出现,不可能预先设计好路线,一蹴而就。因此,若想有创新,就必须有配套机制,允许科研人员大量试错,尽快改进。只要有成熟的机制,能快速迭代、改进,科研人员就不怕犯错,不怕冒险,不怕没有成果,也就不怕再接再厉、不停尝试。因此,要鼓励大胆思考,大胆试验,即便失败了也要表扬、肯定。否则就会形成“丧事当喜事办的坏习惯”,创新也就没戏唱。

创新与机制密不可分 失败也是创新成功的基础

ChatGPT是初创公司的产物,不是大公司,更不是国企,这其中有一定的必然性。大公司激励机制的依据是职工的KPI,但小公司是创业公司,一旦做出了大的成果,公司就可以上市或者收到巨大的市场效益,这种激励举足轻重。如果激励机制不合适,比如所有人都是低工资,那么人们的积极性就会降低;所有人都是高工资,也无法激发进取心与积极性。只有科研人员的投入、兴趣与其回报成正比才能激励人们全力以赴。

德国、日本的工业很发达,但是德国、日本的创新程度依旧不及美国,这是因为它们的激励机制不同。美国的产业是高度市场化的,资金筹集来自于风险投资,而德国、日本依旧依靠大银行资助。

真正的颠覆性的创新,一定来自于市场驱动的机制。风险投资一百个公司,可能九十几个都失败了,成功的只有一两个,但只要有一个成功了,回报就是成千上百倍的。虽然德国、日本也可以做一些辅助性的创新,但是它们的创造很难具有完全的革命性,因为在它们的激励机制下,投资方对成果、回报有要求,创造者就要为错误负责,那么人们就会害怕犯错,小心翼翼不敢轻举妄动,只敢在“安全区”内做一些小成果。而这也再次证明,创新是一种可能,带有必然的风险,如果要求资金投入一定有相应成果,那么一定会扼杀创新的空间。

此外,很多人没有意识到的是,当我们发现一个东西错了,错误本身就是一个非常大的成果,虽然投入的成本泡汤了,但是这个路子不用蹚了,错误选择被排除了,那么我们离最终的成功一定是更近了。

我曾有个机会去美国国家科学基金会(NSF),那里的人给我看了他们之前资助过的项目,其中一些项目好像还有些道理,但是有的看上去就天马行空,似乎是胡说八道。他们却表示,美国NSF资助的项目只会成功不会失败,这是为什么呢?

NSF的人给出了两条解释:第一,真正的创新项目可能看上去就是胡说八道,如果都是自圆其说、在我们理解范围内的东西,那就说明还不够新,所以我们必须要容忍看上去胡说八道或不靠谱的项目,说不定它们就是大成果的孵化器;第二,此类项目一般是由教授和他们指导的研究生去承担。实际上,一个研究生完成了一个失败项目,他本人的收获和对于社会进步的贡献一定比做一个成功的项目更大。而且在美国,即使项目没有正向成果,对失败原因进行有效总结后也可以拿到学位。

这两条解释可以说意味深长、引人深思,尤其是第二条。第二条正是在说明,我们必须要允许人失败、犯错,因为犯错之后,就会收获相应的教训、经验,将来就不会再犯相同的错误,后来者也不会再犯同样的错误,因此犯错也是一种贡献,甚至可能比成功的贡献更大。创新正是在千千万万次尝试与犯错后修正路线、逼近成功,这是个人成长和创新出现的必然且科学的过程,这也是为什么我们必须要有允许犯错的体制机制。

ChatGPT后,教育何为?

ChatGPT可以把海量的信息和数据汇集起来,非常全面,在这一层面上,人类难以望其项背。既然ChatGPT能回答各式各样稀奇古怪、刁钻、偏僻的问题,那我们就要思考,人的价值是什么?如果我们的教育最终让人回答出了与ChatGPT同样的答案,那么教育还有何意义?如果要我回答,教育的价值就应当是培养学生想出不同于ChatGPT的答案的能力,未来教育的目标也应当如此。

因此,未来的教育,应当注意培养批判性思维、逻辑能力,并且允许年轻人畅所欲言、自由思想,再给予他们充分的试错空间。

首先,要培养孩子的批判性思维。有些国家对孩子的教育是,谁说的话都可以被挑战、质疑。而且孩子必须讲不同于老师的话,而不是对老师的观点全盘接受、信以为真。在这种教育理念下,孩子们更倾向于拥有自己的判断,相信自己的判断,勇于质疑。

其次,要培养孩子们的逻辑能力,ChatGPT的回答基本符合人类逻辑,一言一语都有因果关联,都是由前推后、由此及彼,所以它的回答有意义,也能解决我们提出的问题。而我们培养孩子的思考能力、逻辑能力,就是培养他们真正解决现实问题的能力。

第三,要有探索的空间,否则无法创新。为什么 ChatGPT 由初创公司而非大公司创造而成?除激励机制外,还因为社会对它们的容忍度更高,所以初创公司的自由度更高,即便发表了错误、出格的内容大家也并不在意。但对于微软、谷歌等大公司来说,“小心驶得万年船”才是值得恪守的原则,万一出现错误,就难免对名誉造成巨大影响,公司效益也会因而受损。因此,做 AI、 前沿科技的一定是小公司,小公司的自由度更高,不怕犯错,探索空间就更大,而这也证明只有言论自由、思想自由后,探索才能自由,探索自由后,创新才能生根发芽。

未来教育的目标

未来教育的目标是,年轻人会提出正确的问题,并且判断答案是否合理,中间的过程就是人和机器的交互,让机器、人工智能帮助我们去完成很多工作。但这并不代表人与人之间无需再有交流,相反,人和人的交互依然需要,而且更加重要。

知名组织理论家罗素·艾可夫曾提出由数据、信息、知识、智慧组成的知识金字塔。在知识金字塔中,每一层都比下一层多拥有一些特质。数据来源于我们的原始观察与度量,信息来源于我们对数据的筛选、整理与分析,知识则来源于我们对信息的加工、提取与评价,而智慧作为我们独有的能力,意味着我们可以收集、加工、应用、传播知识,以及预测事物的发展与未来走向。

ChatGPT之后,甚至在其出现以前,计算机对于数据处理、信息处理以及知识处理都已经非常在行。虽然机器和人工智能并不“懂”知识,但是它可以存储、调用知识,可以在特定的情境里与人交互,给出的答案也合乎情理。因此,未来的教育应当是教人拥有智慧,而不仅仅是拥有知识、信息与技能。智慧是设计体系结构的能力,而技能仅仅是依照设计搬砖添瓦的能力,智慧与思维是创新真正的来源,而知识与技能则相当次要。

知识金字塔

有些大学为防止学生作弊而禁止其使用ChatGPT,我觉得此举值得商榷。ChatGPT是个工具,是种技术,而技术是道德中立的,关键在于老师应改变传统的考核方式以适应它的出现。斯坦福大学曾统计,50% 的学生做学期论文时都用到了ChatGPT。因此在这种趋势下,老师必须学会如何考核。

一个可用的考核方式是:学生用ChatGPT完成一道题后,必须能给别人讲清楚答案中哪些是对的,又有哪些是错的。可能学生又会把这个问题抛回给ChatGPT,再采用它的答案,但关键是,如果你问得太深入,ChatGPT自己就会“崩溃”,答案也会漏洞百出。在这种情况下,学生就必须要动脑子,要靠自己找到最初答案的漏洞。而老师正可以对这一点做考察,看学生能否找到ChatGPT的漏洞,能找到,就说明学生已将知识掌握透彻。

我们这一代人是“数字移民”,新一代的孩子是“数字原住民”,所以我们一定要为他们创造自由的空间,而不是让他们因循守旧、依照传统行事。

科研的层次与大学的包容

科研必须要区分层次。大型项目是国家发展、社会前进的根本,例如美国NASA牵头的各类航天、物理项目,中国举国体制支持的各种重大项目,这些目的明确、规模投入巨大的项目是不可或缺的。

但与此同时,小型的、看上去“没用”的项目也必须存在。因为科研是一种探索未知的活动,未来哪个项目能开花结果,哪个能“冒泡”,我们当下都是雾里看花,看不真切。所以我们必须要包容一些人,去做一些可能毫无用处的东西,或者是有点出格、方向冷僻的东西,我们必须要让这些人生存,让一些可能存在。

如果大学的考核制度过于严苛,青年教师们只能为了保住自己的工作去做“短平快”、功利性的研究,那么优秀的人无法静心思考真正的问题,只能为科研而科研,只做实用性强的科研,这对于科研是一种实质性的损害。

所以我也有个理论:大学,要培养精神境界高的、有教养的人,还要包容一些特立独行的看似是在胡思乱想的“无用的人”的存在。有些研究当下看似没有一点用处,但可能百年之后就有了大用,这都是我们预料之外的事。

有些全球顶尖大学就会保留不同类型的人才,把一些聪明、能干但怪异、另类的人养在大学里。未来,我们也可以尝试包容各式各样的人才,让他们做些有意思的、胡思乱想的、短期内没有结果甚至没用的东西,或许现在的无心插柳,在未来就变成了夏日炎炎里茂密浓郁的柳荫。

本文根据CERNET网络中心副主任、清华大学电子工程系李星教授报告、访谈整理

整理:王雅静

特别声明:本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者在两周内速来电或来函联系。

退休教授与ChatGPT:科研协作的智能联盟2023/08/04

面对ChatGPT学校教育的变与不变2023/07/25

ChatGPT来了,高等教育如何应对?2023/05/22

ChatGPT将如何影响教育2023/05/15

ChatGPT 能为教育带来什么?2023/05/05

乔姆斯基谈ChatGPT与后者的回应2023/03/08

ChatGPT对教育意味着什么?代表委员热议人工智能技术对教育的影响2023/03/06

京公网安备 11040202430174号

京公网安备 11040202430174号