编辑点评:建设一个安全、绿色、智能、高效的数据中心成为了高校信息化发展的重中之重。本文以北京师范大学IDC机房建设为例,探讨高校IDC机房建设存在的问题,总结经验教训,对于其他高校具有借鉴的价值。

随着高校信息化建设的不断深入以及云计算、大数据、虚拟化的快速应用,对IT基础设施提出了更高的要求,尤其在数据的安全性、可靠性方面,因此建设一个安全、绿色、智能、高效的数据中心成为了高校信息化发展的重中之重。本文以北京师范大学IDC机房建设为例,探讨高校IDC机房建设存在的问题,总结经验教训。

高校IDC机房服务于学校信息化建设中各种IT设备的托管,与商业IDC相比,高校IDC不以盈利为目的,投入少,运维人员不足。在信息化建设过程中,大多数高校没有建设专业化的IDC机房,而是采用与楼宇网络设备共用的方式,这样就造成了众多小机房的出现,单一机房里容纳包括网络设备、服务器、存储等众多IT设备,这些机房规模不大,但承担的任务众多。同时这些机房在安全与节能方案几乎未做规划,供电、制冷等关键系统都没有做冗余配置,管理维护非常困难。

随着大数据、云计算、科研计算快速发展和应用,对IT基础设施的要求也越来越高,这种建设模式已经严重阻碍了信息化的发展。由于信息化需求和技术的多变性,因此在建设前要充分做好规划。高校数据中心投入资金普遍有限,应采用模块化的设计,做好充足资源预留。

模块化、区域分级设计

鉴于学校数据中心各种业务需求的不断发展与变化,各种新技术也在不断出现,故在机房设计时需考虑这些变化对资源需求的改变,以确保整个系统可灵活的扩展。考虑到未来不断发展的需要及投资效益,在机房面积、电力供应、空调容量、通信点数等各个方面都应预留合理的余量及可扩充的灵活性,使计算机机房的投资及今后的发展都得到可靠的保障。因此本次选用的UPS、配电系统、网络系统、制冷系统等都采用模块化,在资金有限的前提下,为以后的扩展做好充分的准备。同时根据不同IT设备对配电和制冷量的需求,机房在建设时采用分区分级的设计模式,分为高密区、中密区、低密区三个区域,分别设计单机柜配电为15kW、6kW、3kW。高密区面向高性能计算、刀片柜等高用电量IT设备。中密区面向虚拟化、存储等设备。低密区面向网络设备、框架式服务器、安全设备等。中低密区PUE控制在1.8以内,高密区PUE控制在1.5以内。

机房子系统设计

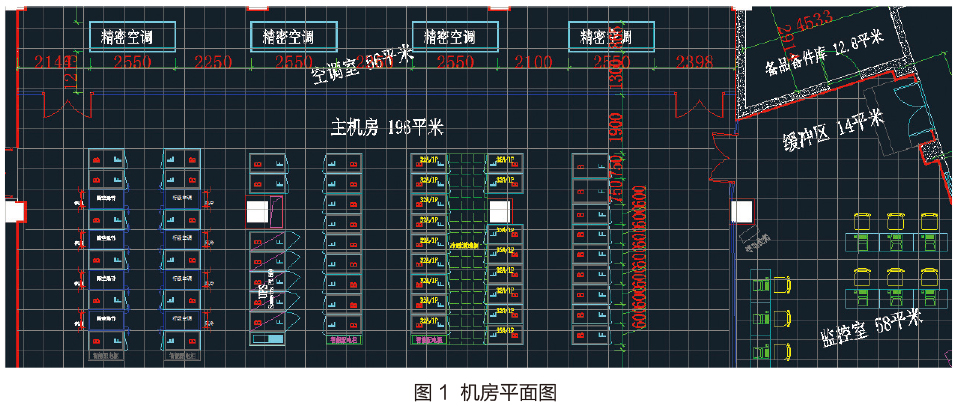

北京师范大学2014年启动新IDC机房建设,以安全、绿色、高效、智能为设计理念,2015年全面投入使用。机房总建筑面积约465平方米,分为主机房区、监控区、配电室、消防室等功能区,如图1所示。机房设计定位为学校教学、科研服务器托管,要求建设一个布局合理、功能完备、设施先进、运行稳定、使用灵活同时又能体现工艺精湛、美观大方、绿色环保的符合国家相关机房标准的现代化计算机中心机房,反映出高性能综合机房所有系统的安全性、功能性、先进性、稳定性、开放性和可管理性。

电气子系统

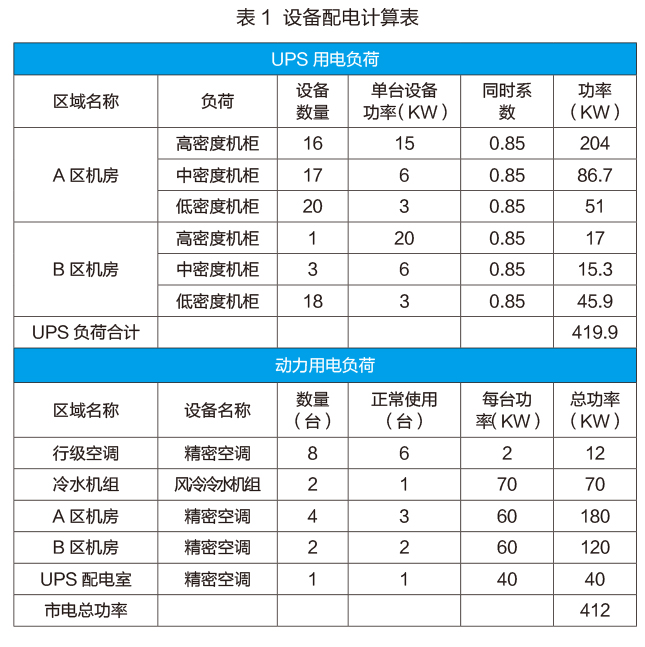

北京师范大学IDC机房配电系统采用国家A级机房建设标准,配电系统由大楼配电室引两路市电电源至机房配电室,电源容量为每路800kW,机房配电柜总开关采用1600A,配电室安装两台400kVAUPS设备组成2N系统提供机房的电力保障。配电系统采用双回路配电结构,一台列头配电柜引自UPS1输出配电柜,另一台列头柜引自UPS2输出配电柜。两台列头柜内的两个独立电气单元分别通过工业连接器连接至机柜内的PUD。每个配电回路均能满足计算机机柜100%的用电负荷,任何一路空开或线路的故障均不影响另一路电源的正常使用。机房每个机柜的用电都经过详细测算,根据不同需求设计用电配制。设备配电表如表1所示。

UPS主要为网络设备、计算机设备、监控、门禁和应急照明系统等提供电源。UPS系统能够在任何市电故障、应急发电机未启动之前,保证为计算机负荷设备等重要设备提供不间断的供电,同时做到稳压改善供电质量的作用。本工程设计采用2台400kVA模块化UPS,电池按照系统满载后备时间0.5小时配置。UPS主机、输入输出配电柜、蓄电池系统放置于数据中心配电室。UPS电源电缆采用专用屏蔽电力电缆沿机柜上的金属桥架敷设到位,这种布线方式具有灵活方便、加线、改线、便于维修等功能,是机房内最为理想的一种布线方式。配电柜由自动空气开关控制,设置过负荷、短路保护等功能,可实现远程对电压、电流监控功能。

数据处理中心供配电系统是机房安全运行动力保证,本项目采用数据中心专用配电柜来规范数据中心供配电系统,根据实际用电情况合理设计配电系统并配置相应输入输出配电柜,保证数据中心供配电系统的安全、合理。在机房供配电系统中,采用热插拔式开关柜,减少由于调整变更带来的不利影响。配电柜所设计的供电路数,能足够提供主机和外部设备的使用,各配电柜均预留有一定数量的备用开关,其中UPS输出配电柜及主机房内UPS区域配电柜各规格的备用输出开关均不少于15%;

制冷子系统

数据中心机房A区共安装53台设备机柜,其中16台高密度机柜,采用风冷冷冻水系统和行级精密空调,剩余为中低密度机柜,精密空调地板下送风的制冷方式。B区机房安装22台设备机柜,采用精密空调地板下送风的制冷方式。A区高密区采用两台风冷冷冻水系统(1主1备),中低密区采用4台精密空调(3主1备),B区采用4台精密空调。

数据中心机房中低密区采用地板下送风的方式,地板高度为450mm,地板下作为静压箱,通过机柜前的开孔地板送风,从而实现空调对机柜的冷却。机柜布局虽然为冷热通道方式,但还是会出现冷风无效冷却,而直接与热风混合的现象,因此把两排机柜中间的冷通道进行封闭,空调机组送出的冷风可以直接送到冷通道内而进入服务器机柜,所有机柜排出的热风被空调机组吸回。从而提高空调机组的回风温度,提高空调机组的制冷能力,还可提高解决机柜更高功率密度的制冷能力。

高密区每机柜采用15kW的配电,对制冷要求极高,因此高密区采用冷通道封闭技术,制冷方式采用风冷冷水机组和机柜行级空调,从而有效降低了冷热风的混合,优化了气流组织,机柜级空调的回风温度可由23℃提升到28℃甚至更高,而每提升1℃回风温度,空调散热量约提高3%~5%,在提升5℃的回风温度下,空调制冷量将提升15%以上。

弱电子系统

本工程采用六类非屏蔽模块化布线加多模光纤解决方案。综合布线系统采用模块化设计,机房均设置弱电列头柜和网络机柜,弱电列头柜敷设铜缆和光纤至网络机柜。数据中心机房共安装有75台设备机柜,其中9台弱电列头机柜和网络机柜,其余66台为服务器机柜,参考设备布置,设计线槽及信息点如下:普通服务器区每台机柜设置36个铜缆信息点,其中24个网络接口,12个KVM接口,汇集到弱电列头柜。弱电列头柜汇聚到本机房的网络机柜。机房区域内弱电线路采用机柜上走线方式,采用开放式线槽。每排机柜配置48芯多模光纤至核心交换机机柜。网络设备采用两台数据中心级三层交换机虚拟成一台,其余二层换交机按照每排机柜进行堆叠提高管理效率。二层交换机采用双万兆上连核心交换机,核心交换机双万兆上联校园网核心交换机。为便于学校各单位远程管理托管的IT设备,IDC机房配套了KVM系统,使得每台服务器可远程安装系统、开关机等操作,减少现场人员的运维成本。

智能监控运维子系统

为保证数据中心机房安全稳定工作,电气系统、环境系统、制冷系统、安防系统等各子系统必须时时刻刻稳定协调运行。如果机房动力及环境设备出现故障,轻则影响业务系统的正常运行,重则造成机房IT设备损坏、报废,使系统陷入瘫痪,后果不堪设想,因此对IDC机房的各系统进行实时集中的监控极其必要。机房环境及动力设备监控系统主要是对机房设备,如配电系统、UPS电源、空调、消防系统、安防系统等的运行状态、温湿度、供电电压电流等的状态进行实时监控并记录历史数据,实现对机房遥测、遥控的管理功能,为机房高效、智能的管理和安全运营提供有力的保证。本项目使用智能监控运维系统将传统的应用监控系统与环境动力监控系统进行整合,实现对服务器、交换机、存储、UPS设备、空调、温湿度、视频、门禁、漏水等的实时监控,大大减少了人员的工作量。

北京师范大学IDC机房以绿色、安全、智能、高效为设计理念,配电、机柜等设施采用模块化设计,便于扩展,同时进行了区域分级建设,引入智能监控系统,IDC机房的建成很好地满足了学校教学、科研对IT基础设施的需求。接下来学校将进一步对IDC机房进行节能方面进行优化。

(作者单位为北京师范大学信息网络中心)